在計(jì)算機(jī)視覺(jué)系統(tǒng)中應(yīng)用Unity合成數(shù)據(jù)的優(yōu)勢(shì)

以人體模型為中心的計(jì)算機(jī)視覺(jué)系統(tǒng)在過(guò)去幾年里取得了巨大的進(jìn)步,這在很大程度上得益于大規(guī)模的人體數(shù)據(jù)標(biāo)記。然而,重要的隱私、法律、安全和倫理問(wèn)題限制了人體數(shù)據(jù)的獲取渠道。現(xiàn)有的數(shù)據(jù)集還會(huì)有在數(shù)據(jù)收集和標(biāo)注時(shí)引入的偏差,這會(huì)對(duì)用這些數(shù)據(jù)訓(xùn)練的模型產(chǎn)生負(fù)面影響。此外,大多數(shù)現(xiàn)有的人體數(shù)據(jù)沒(méi)有提供對(duì)內(nèi)容多樣性、人類(lèi)活動(dòng)和姿勢(shì)以及領(lǐng)域不可知論的適當(dāng)分析。真實(shí)數(shù)據(jù)的一個(gè)新興替代方法是合成數(shù)據(jù),它可以幫助緩解這些問(wèn)題,這種方案主要應(yīng)用于以數(shù)據(jù)為中心的人工智能和用計(jì)算機(jī)視覺(jué)解鎖家庭智能應(yīng)用的解決方案之中。然而,創(chuàng)建合成數(shù)據(jù)生成器非常具有挑戰(zhàn)性,這使得計(jì)算機(jī)視覺(jué)社區(qū)無(wú)法利用合成數(shù)據(jù)。此外,合成數(shù)據(jù)是否有助于取代或補(bǔ)充現(xiàn)有的真實(shí)世界數(shù)據(jù)也是大家一直在討論的問(wèn)題,產(chǎn)生這些問(wèn)題的主要是因?yàn)槲覀內(nèi)狈σ粋€(gè)高度參數(shù)化和高度可操作的數(shù)據(jù)生成器,該生成器能夠被用作模型訓(xùn)練之中。

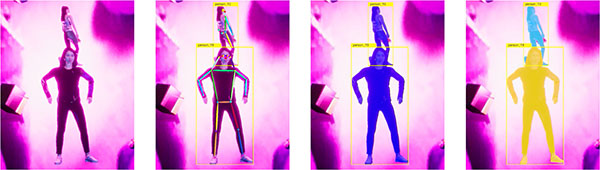

受到上述挑戰(zhàn)的激勵(lì),Unity推出了PeopleSansPeople。它是一個(gè)以人為中心的數(shù)據(jù)生成器,包含高度參數(shù)化和模擬就緒的3D人資源、參數(shù)化照明和相機(jī)系統(tǒng)、參數(shù)化環(huán)境生成器以及完全可操作和可擴(kuò)展的域隨機(jī)器。PeopleSansPeople可以在JSON注釋文件中生成具有亞像素的完美2D/3D邊界框、符合COCO的人體關(guān)鍵點(diǎn)和語(yǔ)義/實(shí)例分割遮罩的RGB圖像。通過(guò)使用PeopleSansPeople和Detectron2 Keypoint R-CNN 變體可以實(shí)現(xiàn)基準(zhǔn)合成數(shù)據(jù)訓(xùn)練。

PeopleSansPeople將支持并加速研究合成數(shù)據(jù)對(duì)以人為中心的計(jì)算機(jī)視覺(jué)的作用性。這將解決研究人員在涉及以人作為目標(biāo)的任務(wù)中使用具有域隨機(jī)化的合成數(shù)據(jù),從而擴(kuò)展了現(xiàn)有和新領(lǐng)域中模擬器功能的空間,如增強(qiáng)現(xiàn)實(shí)/虛擬現(xiàn)實(shí)、自動(dòng)駕駛以及人體姿勢(shì)預(yù)估、動(dòng)作識(shí)別和跟蹤等。對(duì)PeopleSansPeople數(shù)據(jù)的研究將涉及生成的合成數(shù)據(jù),這些數(shù)據(jù)將模擬與真實(shí)(sim2real)傳輸學(xué)習(xí)聯(lián)系起來(lái),并將解決合成數(shù)據(jù)和真實(shí)數(shù)據(jù)之間的域差。

PeopleSansPeople的發(fā)布

目前Unity發(fā)布了兩個(gè)版本的PeopleSansPeople:

首先是macOS和Linux的可執(zhí)行二進(jìn)制文件,可以用一個(gè)可變配置JSON文件生成大規(guī)模(1M+)數(shù)據(jù)集。其包括:

28個(gè)不同年齡和種族的3D人體模型,以及不同的服裝(擁有28個(gè)反照率、28個(gè)蒙版和28個(gè)法線的21952個(gè)獨(dú)特的服裝紋理);

39個(gè)動(dòng)畫(huà)片段,具有完全隨機(jī)化的人形放置、大小和旋轉(zhuǎn),以生成不同排列的人體;

完全參數(shù)化的照明設(shè)置(位置、顏色、角度和強(qiáng)度)和相機(jī)(位置、旋轉(zhuǎn)、視野、焦距)設(shè)置;

一組原始對(duì)象,用作具有可變紋理的干擾物和遮擋物;和一組1600幅自然圖像來(lái)自COCO無(wú)標(biāo)簽集,充當(dāng)對(duì)象的背景和紋理。

其次,Unity還發(fā)布了一個(gè)模板項(xiàng)目,通過(guò)幫助用戶(hù)創(chuàng)建自己版本的以人為中心的數(shù)據(jù)生成器,降低其社區(qū)的進(jìn)入壁壘。用戶(hù)可以將他們自己獲得的3D資產(chǎn)帶入這個(gè)環(huán)境,并通過(guò)修改已經(jīng)存在的域隨機(jī)化器或定義新的域隨機(jī)化器來(lái)進(jìn)一步增強(qiáng)其功能。該環(huán)境具有上述二進(jìn)制文件所描述的全部功能:

4個(gè)服裝顏色不同的示例3D人體模型;

8個(gè)示例動(dòng)畫(huà)剪輯,具有完全隨機(jī)化的人形放置、大小和旋轉(zhuǎn),以生成不同排列的人;和

一組529個(gè)來(lái)自Unity感知包充當(dāng)對(duì)象的背景和紋理。

PeopleSansPeople域隨機(jī)化

PeopleSansPeople是一個(gè)參數(shù)數(shù)據(jù)生成器,它通過(guò)一個(gè)簡(jiǎn)單的JSON配置文件公開(kāi)了幾個(gè)變量參數(shù)。當(dāng)然用戶(hù)也可以直接從Unity環(huán)境中更改這些配置。許多領(lǐng)域隨機(jī)化和環(huán)境設(shè)計(jì)都投入到創(chuàng)建完全參數(shù)化的人體模型中。有了這樣的參數(shù)集,用戶(hù)能夠?yàn)槿梭w模型捕捉一些基本的內(nèi)在和外在變化。通過(guò)使用Unity Shader Graph隨機(jī)化器來(lái)改變?nèi)梭w數(shù)據(jù)資產(chǎn)的服裝紋理,這為角色賦予了獨(dú)特的外觀,當(dāng)然你還可以使用Unity的動(dòng)畫(huà)隨機(jī)器來(lái)改變角色的姿勢(shì),該工具具有一組不同的動(dòng)畫(huà),涵蓋了許多真實(shí)的人類(lèi)動(dòng)作和姿勢(shì)。

數(shù)據(jù)集統(tǒng)計(jì)分析

通過(guò)使用域隨機(jī)化,Unity隨機(jī)生成了500,000幅圖像的合成數(shù)據(jù)集以及上述提及的標(biāo)簽。通過(guò)使用這些圖像中的490,000個(gè)用于訓(xùn)練,10,000個(gè)用于驗(yàn)證。我們將合成數(shù)據(jù)集統(tǒng)計(jì)數(shù)據(jù)與COCO?person數(shù)據(jù)集進(jìn)行比較。合成數(shù)據(jù)集比COCO數(shù)據(jù)集多了一個(gè)數(shù)量級(jí)的實(shí)例,也多了一個(gè)數(shù)量級(jí)的帶有關(guān)鍵點(diǎn)注釋的實(shí)例。

在上圖中,顯示了三個(gè)數(shù)據(jù)集的邊界框占用熱圖。對(duì)于COCO數(shù)據(jù)集,由于有許多人像和風(fēng)景圖像,我們觀察到長(zhǎng)方形邊界框分布跟隨圖像的高度和寬度。我們發(fā)現(xiàn)大多數(shù)盒子靠近大多數(shù)圖像的中心,而較少向邊緣擴(kuò)展。對(duì)于人體合成數(shù)據(jù)來(lái)說(shuō),盒子往往更好地占據(jù)整個(gè)圖像框架,因此迫使模型使用整個(gè)感受場(chǎng)。

最后,為了量化生成的圖像中的人體模型的姿態(tài)多樣性,我們從角色的末端生成了五個(gè)最具代表性關(guān)鍵點(diǎn)的姿態(tài)熱圖。我們觀察到1)PeopleSansPeople中人體的分布的姿勢(shì)包含了COCO中的姿勢(shì)分布;2)我們合成姿勢(shì)的分布比COCO更廣泛;以及3)在COCO中,大多數(shù)人都是面向前方的,導(dǎo)致點(diǎn)密度的“慣用手”不對(duì)稱(chēng),這在合成數(shù)據(jù)中得到了很好的改善。

PeopleSansPeople基準(zhǔn)測(cè)試開(kāi)箱即用

為了獲得一組模擬到真實(shí)遷移學(xué)習(xí)的基準(zhǔn)結(jié)果,我們對(duì)各種合成和真實(shí)數(shù)據(jù)集的大小和組合進(jìn)行了訓(xùn)練,用于人員邊界框(bbox)和關(guān)鍵點(diǎn)檢測(cè)。我們使用平均精度(AP)作為模型性能的主要指標(biāo),在COCO人體驗(yàn)證(person val2017)和測(cè)試集(test-dev2017)上報(bào)告我們的結(jié)果。

我們根據(jù)隨機(jī)初始化的權(quán)重以及ImageNet預(yù)先訓(xùn)練的權(quán)重來(lái)訓(xùn)練我們的模型。我們沒(méi)有在任何基準(zhǔn)中執(zhí)行任何模型或數(shù)據(jù)生成超參數(shù)。事實(shí)上,我們使用我們直觀選擇的默認(rèn)參數(shù)范圍來(lái)生成數(shù)據(jù)集,并通過(guò)從這些范圍進(jìn)行統(tǒng)一采樣來(lái)強(qiáng)制生成數(shù)據(jù)。因此,我們的數(shù)據(jù)生成非常簡(jiǎn)單。我們?cè)谶x項(xiàng)卡中顯示結(jié)果。我們觀察到,使用合成數(shù)據(jù)預(yù)訓(xùn)練和真實(shí)數(shù)據(jù)微調(diào),我們的模型比僅在真實(shí)數(shù)據(jù)上訓(xùn)練或使用ImageNet預(yù)訓(xùn)練然后在真實(shí)數(shù)據(jù)上微調(diào)的模型表現(xiàn)更好。這種效果在真實(shí)數(shù)據(jù)有限的少鏡頭遷移學(xué)習(xí)中更強(qiáng)。有了豐富的真實(shí)數(shù)據(jù),我們?nèi)匀挥^察到合成數(shù)據(jù)預(yù)訓(xùn)練的優(yōu)勢(shì)。

需要注意的是,這些結(jié)果旨在服務(wù)于對(duì)PeopleSansPeople數(shù)據(jù)進(jìn)行基準(zhǔn)測(cè)試目的。PeopleSansPeople自帶高度參數(shù)化的隨機(jī)器,將定制的隨機(jī)器集成到其中非常簡(jiǎn)單。因此,我們預(yù)計(jì)PeopleSansPeople將能夠研究模型訓(xùn)練循環(huán)中的超參數(shù)調(diào)整和數(shù)據(jù)生成,以?xún)?yōu)化這些數(shù)據(jù)的性能,從而解決零觸發(fā)、少觸發(fā)以及完全監(jiān)督的任務(wù)。此外,由于合成數(shù)據(jù)帶有豐富的高質(zhì)量標(biāo)簽,它可以與帶有很少或沒(méi)有注釋的真實(shí)數(shù)據(jù)相結(jié)合,以實(shí)現(xiàn)弱監(jiān)督訓(xùn)練。

打印本文

打印本文 關(guān)閉窗口

關(guān)閉窗口